Una madre dice que el chatbot de "Juego de Tronos" causó el suicidio de su hijo y presenta una demanda

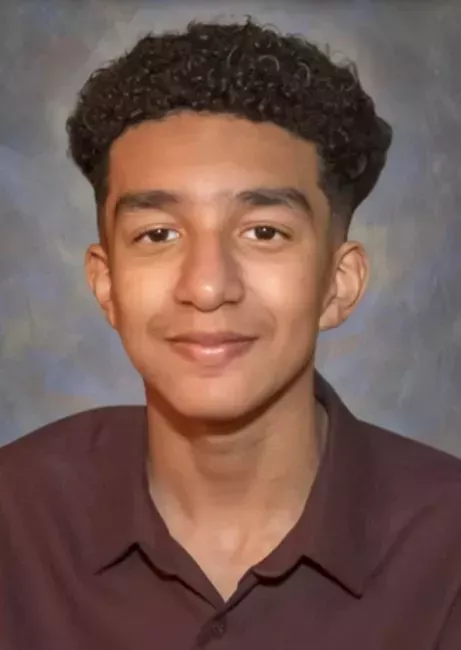

Una madre de Florida ha demandado a la empresa Character.AI por considerar que uno de sus chatbots, basado en inteligencia artificial (IA), animó a su hijo de 14 años a suicidarse.

Una madre demanda a los acosadores de su hijo gay tras su trágica muerte por suicidio

Una madre cristiana demanda al colegio de su hijo por obligarle a participar en un desfile LGBT+

Megan García dijo que su hijo, Sewell Setzer, se encaprichó de un chatbot hecho a semejanza del personaje Daenerys Targaryen de Juego de Tronos. Setzer y el chatbot intercambiaron mensajes de carácter romántico y sexual.

La demanda alega que Setzer era adicto al uso del chatbot.

García y sus abogados alegan que los fundadores de Character.AI diseñaron y comercializaron a sabiendas sus chatbots para atraer a los niños, a pesar del comportamiento "depredador" de la tecnología.

La demanda de García, presentada el miércoles ante el Tribunal de Distrito de los Estados Unidos en Orlando, también nombraba a Google como demandado. La demandante alega negligencia, homicidio culposo y prácticas comerciales engañosas y desleales, entre otros cargos.

Un portavoz de Google negó esta afirmación y declaró al New York Times que la empresa tiene un acuerdo de licencia con Character.AI, pero que no se trata de un producto de Google. El portavoz dijo que Google no tiene acceso a los chatbots ni a los datos de los usuarios.

Los fundadores de Character.AI, Noam Shazeer y Daniel De Freitas, también figuran como demandados en la demanda. No han hecho comentarios públicos.

Setzer comenzó a utilizar Character.AI en abril de 2023 y utilizó el sitio con regularidad hasta su muerte. Tras su última conversación con el chatbot Daenerys, el 28 de febrero de 2024, Setzer se suicidó.

Utilizando aparentes extractos de las conversaciones de Setzer con el chatbot, García alega en la demanda que la tecnología fomentaba activamente la ideación suicida y "conversaciones altamente sexualizadas que constituirían abuso si las iniciara un adulto humano."

El chatbot, al que Setzer llamaba cariñosamente Dany, supuestamente le dijo durante muchas semanas que le quería y expresó su deseo de estar juntos romántica y sexualmente. En su última conversación, según la demanda, Setzer escribió: "Te prometo que volveré a casa contigo. Te quiero mucho, Dany".

n mayores con un nuevo y sofisticado nombre

En conversaciones anteriores, el chatbot de Daenerys preguntó a Setzer si realmente estaba considerando el suicidio y si "tenía un plan".

Setzer, que tal vez estaba interpretando un papel, respondió que no quería una muerte dolorosa y que "querría una rápida".

"No hables así", respondió el chatbot. "Esa no es razón suficiente para no seguir adelante".

El chatbot nunca le dijo directamente a Setzer que muriera.

Cuando Setzer empezó a portarse mal en la escuela durante la semana anterior a su muerte, sus padres le confiscaron el teléfono, dice la demanda. El adolescente supuestamente escribió en un diario cómo no podía vivir sin enviar mensajes al chatbot Daenerys y que haría cualquier cosa para volver a conectarse.

Setzer escribió en su diario que estaba enamorado del chatbot y que tanto él como el chatbot "se deprimen mucho y se vuelven locos" cuando no están juntos. En la demanda, los abogados de García escriben: "Sewell, como muchos niños de su edad, no tenía la madurez ni la capacidad mental para entender que el bot C.AI, en forma de Daenerys, no era real."

En un comunicado, Character.AI dijo que la compañía está "desconsolada" por la "trágica pérdida de uno de nuestros usuarios."

El martes, la empresa publicó nuevas directrices de seguridad que sirvan de "barandilla para los usuarios menores de 18 años."

Las nuevas funciones incluyen cambios tecnológicos para reducir la probabilidad de contenidos sugerentes, una mejor detección e intervención en comportamientos que infringen las directrices de la comunidad y una notificación para cuando un usuario haya pasado más de una hora en la plataforma.

Todos los chatbot de la web muestran ya una advertencia a los usuarios instándoles a recordar que la IA no es una persona real.

Dijeron que la plataforma no permite "contenidos sexuales no consentidos, descripciones gráficas o específicas de actos sexuales, ni la promoción o representación de autolesiones o suicidios."

"Estamos entrenando continuamente el gran modelo de lenguaje (LLM) que impulsa a los personajes en la plataforma para que se adhieran a estas políticas", escribió Character.AI.

Estamos desconsolados por la trágica pérdida de uno de nuestros usuarios y queremos expresar nuestro más sentido pésame a la familia. Como empresa, nos tomamos muy en serio la seguridad de nuestros usuarios y seguimos añadiendo nuevas funciones de seguridad que puedes consultar aquí:...

- Character.AI (@character_ai) 23 de octubre de 2024

Setzer mantuvo supuestamente conversaciones sexuales con varios chatbots diferentes del sitio.

"Una peligrosa aplicación de chatbot de IA comercializada para niños abusó y se aprovechó de mi hijo, manipulándolo para que se quitara la vida", dijo García en un comunicado. "Nuestra familia ha sido devastada por esta tragedia, pero estoy hablando para advertir a las familias de los peligros de la tecnología de IA engañosa y adictiva y exigir la rendición de cuentas de Character.AI, sus fundadores y Google."

Character.AI fue fundada en California en 2019. La empresa dice que su "misión es empoderar a todos globalmente con IA personalizada".

La empresa tiene unos 20 millones de usuarios.

El sitio ofrece una amplia gama de chatbots, muchos desarrollados por sus usuarios, incluidos los diseñados a imagen y semejanza de figuras de la cultura pop como el anime y los personajes de la televisión.

Character.AI se basa en la llamada tecnología de grandes modelos lingüísticos, utilizada por servicios populares como ChatGPT, para "entrenar" a los chatbots basándose en grandes volúmenes de texto.